TensorRT LLM加速Gemma!NVIDIA与谷歌牵手,RTX助推AI聊天:NVIDIA推出最新AI聊天技术,谷歌合作加速发展

这两家公司的团队密切合作,主要是使用NVIDIA TensorRT LLM加速谷歌Gemma开源模型的性能。开源模型Gemma采用与Gemini模型相同的底层技术构建,而NVIDIA TensorRT LLM是一个开源库,用于在数据中心的NVIDIA GPU、云服务器以及带有NVIDIA RTX GPU的PC上运行时,可以极大优化大型语言模型推理。这也这使得开发人员能够完全利用全球超过1亿台数量的RTX GPU AI PC完成自己的工作。

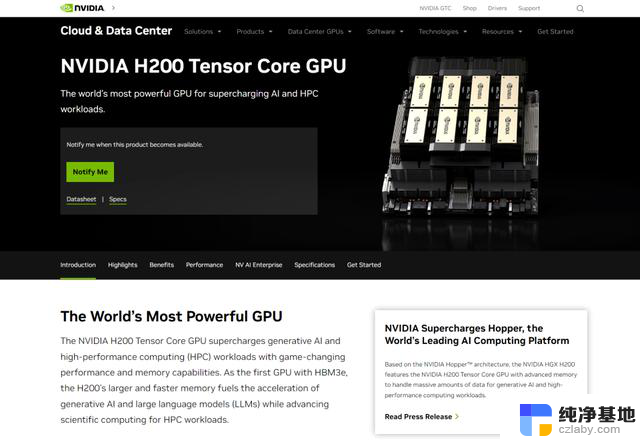

同时,开发人员还可以在云计算服务器中的NVIDIA GPU上运行Gemma,包括在谷歌云基于H100 Tensor Core GPU,以及很快谷歌将于今年部署的NVIDIA H200 TensorCore GPU——该GPU具有141GB的HBM3e内存,内存带宽可以达到4.8TB/s。

另外,企业开发人员还可以利用NVIDIA丰富的工具生态系统,包括具有NeMo框架的NVIDIA AI Enterprise和TensorRT LLM,对Gemma进行微调,并在其生产应用程序中部署优化模型。

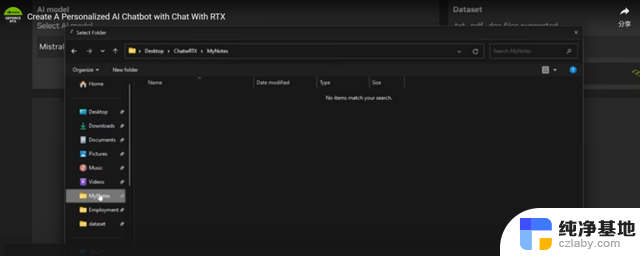

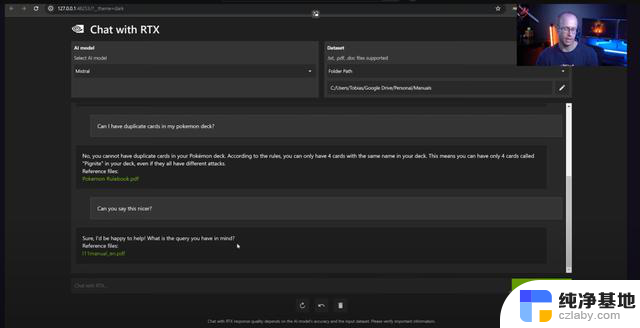

NVIDIA表示,先期上线支持Gemma的是Chat with RTX,这是一款NVIDIA技术演示应用,使用检索增强生成和TensorRT LLM扩展,在基于RTX GPU的本地Windows PC上为用户提供生成式AI应用的功能。通过RTX聊天,用户可以轻松地将PC上的本地文件连接到大型语言模型,从而使用自己的数据对聊天机器人进行个性化设置。

由于该模型在本地运行,因此可以快速提供结果,并且用户数据保留在设备上。与基于云的LLM服务不同,使用Chat with RTX聊天可以让用户在本地PC上处理敏感数据,而无需与第三方共享或连接互联网。

TensorRT LLM加速Gemma!NVIDIA与谷歌牵手,RTX助推AI聊天:NVIDIA推出最新AI聊天技术,谷歌合作加速发展相关教程

-

微软推出首款自制AI芯片,发布自定义AI助手平台,引领智能助手技术发展

微软推出首款自制AI芯片,发布自定义AI助手平台,引领智能助手技术发展2023-11-19

-

CES 2024丨NVIDIA引领AI汽车技术创新,推动人工智能进一步发展

CES 2024丨NVIDIA引领AI汽车技术创新,推动人工智能进一步发展2024-01-09

-

微软和谷歌高管访问印度推广人工智能应用,加速印度人工智能应用发展

微软和谷歌高管访问印度推广人工智能应用,加速印度人工智能应用发展2024-02-01

-

- 英伟达(Nvidia)与AMD在AI领域的技术竞争力对比

- 微软推出全新Copilot键,科创板50ETF(588080)一键布局AI PC发展机会

- 微软加码推动整合AI能力,Office 365付费用户突破4亿

- NVIDIA NVLink概述:极速连接技术详解

- nVidia RTX SUPER GPU震撼发布,AI能力全面升级!-全面提升的AI能力与震撼发布

- 微软加入自定义GPT大战:AI技术新纪元的序幕,掀起AI技术革新的篇章

- 浅谈国产六大CPU芯片厂商:发展现状与前景分析

- 微软秘密开发首个千亿大模型,竟由OpenAI对手操刀!- 一窥微软最新AI技术突破

- 华硕官网泄露AMD锐龙AI 9 HX 170处理器:12核24线程性能曝光

- 国内会有吗?曝英伟达今年仅发布RTX 5090显卡,国内上市情况如何?

- 微软大客户订单激增,美国云计算三巨头继续保持高增长

- 近40亿美元投资,微软在东南亚疯狂加码|SEA Now: 微软在东南亚市场投入巨资,加速扩张

微软资讯推荐

- 1 浅谈国产六大CPU芯片厂商:发展现状与前景分析

- 2 微软秘密开发首个千亿大模型,竟由OpenAI对手操刀!- 一窥微软最新AI技术突破

- 3 国内会有吗?曝英伟达今年仅发布RTX 5090显卡,国内上市情况如何?

- 4 Windows 10市场份额重返 70% Windows 11继续下滑:用户回归主流操作系统

- 5 全新显卡推荐:2021年最佳显卡推荐及性能对比

- 6 NVIDIA已悄悄推出新RTX 4070,改用AD103核心,性能如何?

- 7 今天小编分享 显卡进口攻略!以及显卡进口关税!最新解析

- 8 前白宫网络政策主管:微软是美国国家安全威胁的真相揭露

- 9 微软推出新型AI工具VASA-1,可将照片转化为逼真视频,让您的照片动起来

- 10 英伟达股价重挫1.8个宁德时代,AI龙头是否面临风险?

win10系统推荐

系统教程推荐