NVIDIA NVLink概述:极速连接技术详解

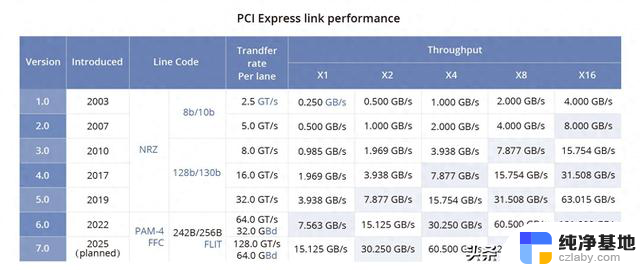

NVLink是一种解决服务器内GPU之间通信限制的协议。与传统的PCIe交换机不同,NVLink带宽有限,可以在服务器内的GPU之间实现高速直接互连。第四代NVLink提供更高的带宽,每条通道达到112Gbps,比PCIe Gen5通道速率快三倍。

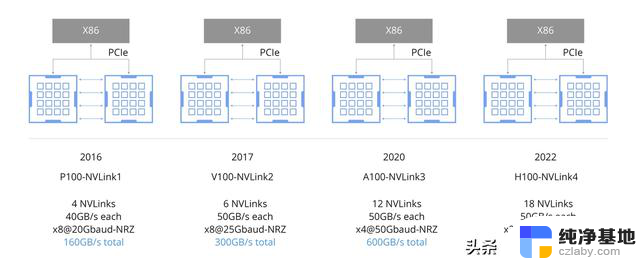

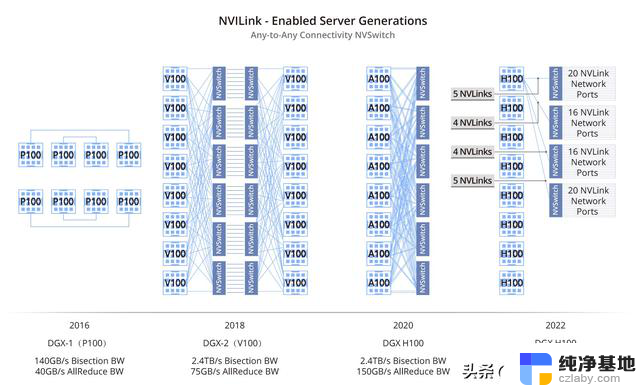

NVLink旨在为GPU直接互连提供简化、高速、点对点的网络,相比传统网络减少了开销。通过在不同层次提供CUDA加速,NVLink减少了与通信相关的网络开销。NVLink随着GPU架构的演进不断发展,从P100的NVLink1到H100的NVLink4,如图所示。NVLink 1.0、NVLink 2.0、NVLink 3.0和NVLink 4.0之间的关键区别在于连接方式、带宽和性能。

NVSwitch芯片

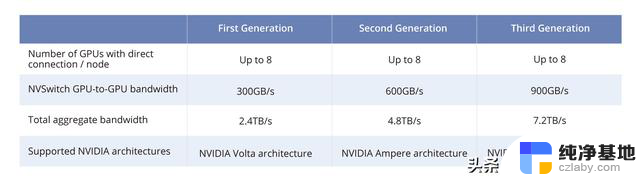

NVSwitch芯片NVSwitch芯片是一种物理芯片,类似于交换机ASIC,可通过高速的NVLink接口连接多个GPU,提高服务器内的通信和带宽。第三代NVIDIA NVSwitch可支持以900 GB/s的速率互连每对GPU。

NVSwitch3芯片具有64个NVLink4端口,提供总共12.8 Tbps的单向带宽或3.2 TB/s的双向带宽。NVSwitch3芯片的独特之处在于其集成了SHARP功能,对多个GPU单元的计算结果进行聚合和更新,减少网络数据包并提高计算性能。

NVLink服务器

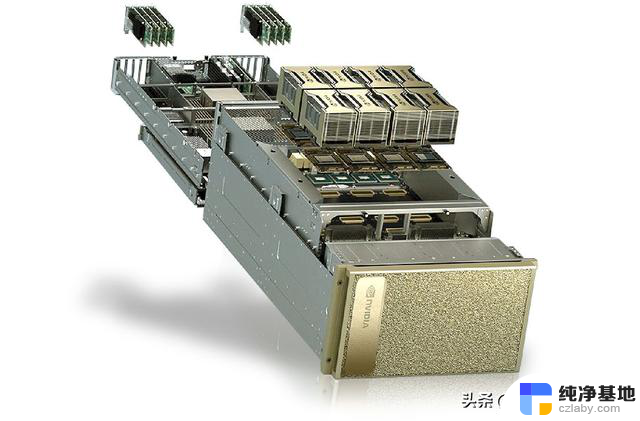

NVLink服务器NVLink服务器采用NVLink和NVSwitch技术连接GPU,通常可在英伟达(NVIDIA)的DGX系列服务器或具有类似架构的OEM HGX服务器中找到。这些服务器利用NVLink技术,提供出色的GPU互联性、可扩展性和高性能计算能力。2022年,英伟达(NVIDIA)宣布推出第四代NVIDIA® DGX™系统,这是世界上首个采用新的NVIDIA DGX H100服务器构建的AI平台。

因此,NVLink服务器在科学计算、人工智能、大数据处理和数据中心等关键领域已经变得不可或缺。通过提供强大的计算能力和高效的数据处理,NVLink服务器不仅满足了这些领域的严格要求,还推动了这些领域的进步和创新。

NVLink交换机

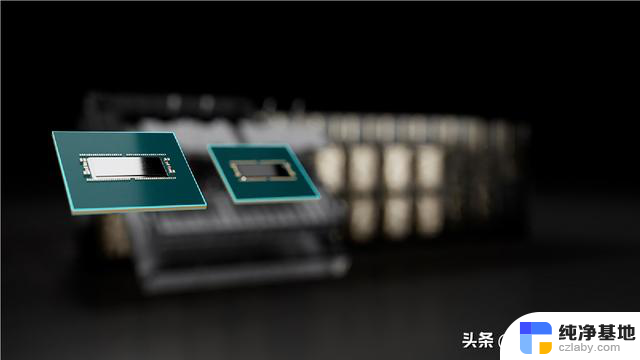

NVLink交换机2022年,英伟达(NVIDIA)将NVSwitch芯片独立出来,并制作成NVLink交换机,用于连接主机之间的GPU设备。它采用了1U尺寸设计,具有32个OSFP端口;每个OSFP端口包含8个112G PAM4通道,每个交换机内置2个NVSwitch3芯片。

NVLink网络

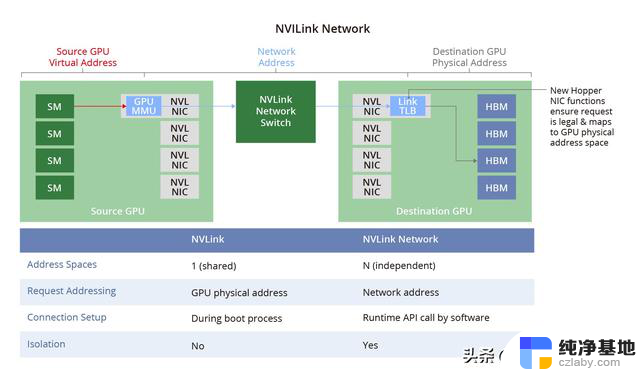

NVLink网络NVSwitch物理交换机将多个NVLink GPU服务器连接成一个大型Fabric网络,即NVLink网络。解决了GPU之间的高速通信带宽和效率问题。每个服务器都有独立的地址空间,为NVLink网络中的GPU提供数据传输、隔离和安全保护。当系统启动时,NVLink网络通过软件API自动建立连接,并可以在运行过程中更改地址。

该图比较了NVLink网络与传统以太网网络,演示了如何创建独立于IP以太网并专用于GPU服务的NVLink网络。

概念

传统实例

NVLink网络

物理层

400G电/光介质

定制固件 OSFP

数据链路层

以太网

NVLink定制芯片上的硬件和固件

网络层

IP

新NVLink网络寻址和管理协议

传输层

TCP

NVLink定制芯片上的硬件和固件

会话层

Socket

SHARP组 CUDA导出数据结构的网络地址

应用层

HTTP/FTP

AI框架或用户应用程序

网卡

PCIe网卡 (网卡或芯片)

嵌入在GPU和NVSwitch中的函数

RDMA卸载

网卡卸载引擎

GPU内部复制引擎

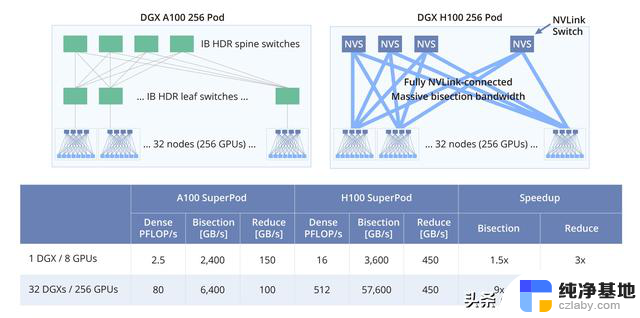

InfiniBand网络 VS NVLink网络InfiniBand网络和NVLink网络是在高性能计算和数据中心应用中使用的两种不同的网络技术。它们有以下区别:

架构和设计:InfiniBand网络是一种采用多通道、高速串行连接的开放标准网络技术,支持点对点和多播通信。NVLink网络是由英伟达(NVIDIA)开发的专有技术,旨在实现GPU之间的高速直连。

应用场景:InfiniBand网络广泛应用于高性能计算集群和大规模数据中心。NVLink网络主要用于大规模GPU集群、HPC、人工智能等领域。

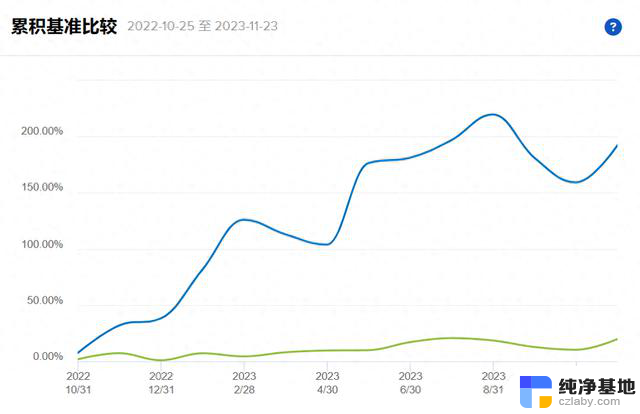

带宽和延迟:InfiniBand网络提供高带宽和低延迟的通信,提供更高的吞吐量和更短的传输延迟。NVLink网络为GPU之间提供更高的带宽和更低的延迟,以支持快速数据交换和协同计算。以下是使用NVLink网络的H100和使用InfiniBand网络的A100之间的带宽比较。

结论

结论NVIDIA NVLink作为一项开创性的技术,彻底改变了高性能计算和人工智能领域。它能够增强GPU之间的通信,提高性能,并实现无缝的并行处理,成为众多高性能计算和人工智能应用中不可或缺的组成部分。随着先进计算领域的不断发展,NVLink的重要性和影响力将不断扩大,推动技术创新。

NVIDIA NVLink概述:极速连接技术详解相关教程

-

-

微软加入自定义GPT大战:AI技术新纪元的序幕,掀起AI技术革新的篇章

微软加入自定义GPT大战:AI技术新纪元的序幕,掀起AI技术革新的篇章2023-11-19

-

英伟达(Nvidia)与AMD在AI领域的技术竞争力对比

英伟达(Nvidia)与AMD在AI领域的技术竞争力对比2023-11-25

-

国产CPU龙芯3A6000同频秒杀Intel 14代酷睿,揭秘其背后的技术原因

国产CPU龙芯3A6000同频秒杀Intel 14代酷睿,揭秘其背后的技术原因2023-11-29

- CES 2024丨NVIDIA引领AI汽车技术创新,推动人工智能进一步发展

- 微软战略大转变:拥抱小模型!掀起技术浪潮

- 微软的崛起:一个有远见的人与一个技术官僚的故事

- 2060显卡属于什么档次 2060显卡性能详细介绍:一文详解2060显卡性能及档次

- Win10自带投屏功能怎么用?职场办公干货,快速掌握投屏技巧!

- 『2024』如何注册微软商店账号?教程详解

- Win10和Win7哪个好用?比较两个操作系统的优劣

- AMD 8400F性能和游戏体验评测:值得入手吗?

- 英伟达正式宣布“反转”计划,外媒称现在为时已晚

- 30 天倒计时警告,Windows 10 21H2 即将来临!别忘了更新系统

- 微软Win11更新22000.2960(KB5037770)修复了影响IE模式问题

- GPT-4o模型登陆微软Azure OpenAI服务,革新中文SEO技术!

微软资讯推荐

- 1 Win10和Win7哪个好用?比较两个操作系统的优劣

- 2 英伟达正式宣布“反转”计划,外媒称现在为时已晚

- 3 GPT-4o模型登陆微软Azure OpenAI服务,革新中文SEO技术!

- 4 微软承认部分Win11设备卡在26040/23620无法升级,解决方法大揭秘

- 5 浅谈国产六大CPU芯片厂商:发展现状与前景分析

- 6 微软秘密开发首个千亿大模型,竟由OpenAI对手操刀!- 一窥微软最新AI技术突破

- 7 国内会有吗?曝英伟达今年仅发布RTX 5090显卡,国内上市情况如何?

- 8 Windows 10市场份额重返 70% Windows 11继续下滑:用户回归主流操作系统

- 9 全新显卡推荐:2021年最佳显卡推荐及性能对比

- 10 NVIDIA已悄悄推出新RTX 4070,改用AD103核心,性能如何?

win10系统推荐

系统教程推荐