阿里云弹性计算升级:CPU上跑推理,模型建成本降低50%

编辑|邓咏仪

1月11日,阿里云升级第八代企业级通用计算实例ECS g8i产品。新产品依托于英特尔在2023年12月发布的第五代至强可扩展处理器,以及阿里云自研的“飞天+CIPU”架构体系所搭建。

升级之后,新产品的在算力、网络、性能、应用场景方面有能力提升:

算力层,ECS g8i实例的ECS g8i实例的L3缓存容量提升到320MB,内存速率提升至5600MT/s;性能方面,整机性能提升了85%,单核性能提升25%;网络方面,PPS达3000万,时延低至8微秒;场景上,新的ECS g8i实例可将MySQL数据库的性能提升至60%,Redis和Nginx的性能分别提升40%和24%。面对目前火热的大模型需求,新升级的ECS g8i实例进行了升级优化,让大模型跑在CPU上,并有效降低了模型搭建成本。

这对于大模型的商业化落地意味着全新的尝试。一般而言,CPU在浮点、并行维度和内存宽带上都与GPU能力相差甚远,让模型跑在CPU上是一件困难的事。

在技术,ECS g8i上做了一次新的尝试。为了解决首包延迟和吞吐性能技术难题,ECS g8i实例进行了针对性的技术优化,其内置指令集从AVX512升级到了Intel AMX高级矩阵扩展加速技术,可以加速模型运行。

有了加速能力之后,模型推理过程在CPU上也能跑通,大大降低了大模型搭建和推理成本。此外,CPU相较GPU而言,更容易获取,成本也更低,所以,这也为解决算力短缺难题打开了新可能。

阿里云弹性计算产品线总经理张献涛表示:“g8i可更迅速地响应中小规模参数模型,运行知识检索、问答系统及摘要生成等AI工作负载时。起建成本相比A10 GPU云服务器下降50%。”

阿里云新发布的ECS g8i产品

目前,在CPU上,ECS g8i不仅能支持中小模型的推理计算,还可以支撑72B参数级别的大语言模型分布式推理。以阿里云通义千问开源的Qwen-72B大模型为例,它可在g8i实例eRDMA网络构建的集群实现高效运行。输入小于500字时,首包延时小于3秒,每秒可生成7个Token。

此外,ECS g8i还能支持超过32batchsize的超大参数规模的AI模型负载,涵盖目前市面上的文生图、AI生成代码、虚拟助手以及创意辅助工具等多类模型。

在实际的模型落地中,要结合场景端的需求,综合考量效果和成本。根据阿里云的测试,通过CPU做超高并发,可以充分利用算力,进行长时间计算和推理。目前,ECS g8i在一些对实时性要求不高的离线场景,比如创意广告生成、离线视频摘要生成等AI功能方面,已经有良好的效果。

阿里云弹性计算升级:CPU上跑推理,模型建成本降低50%相关教程

-

天检说法:不翼而飞的CPU——如何防止计算机处理器失踪

天检说法:不翼而飞的CPU——如何防止计算机处理器失踪2023-12-12

-

材料学突破!微软MatterGen超越最先进模型,直接生成新材料稳定性提升2.9倍

材料学突破!微软MatterGen超越最先进模型,直接生成新材料稳定性提升2.9倍2023-12-08

-

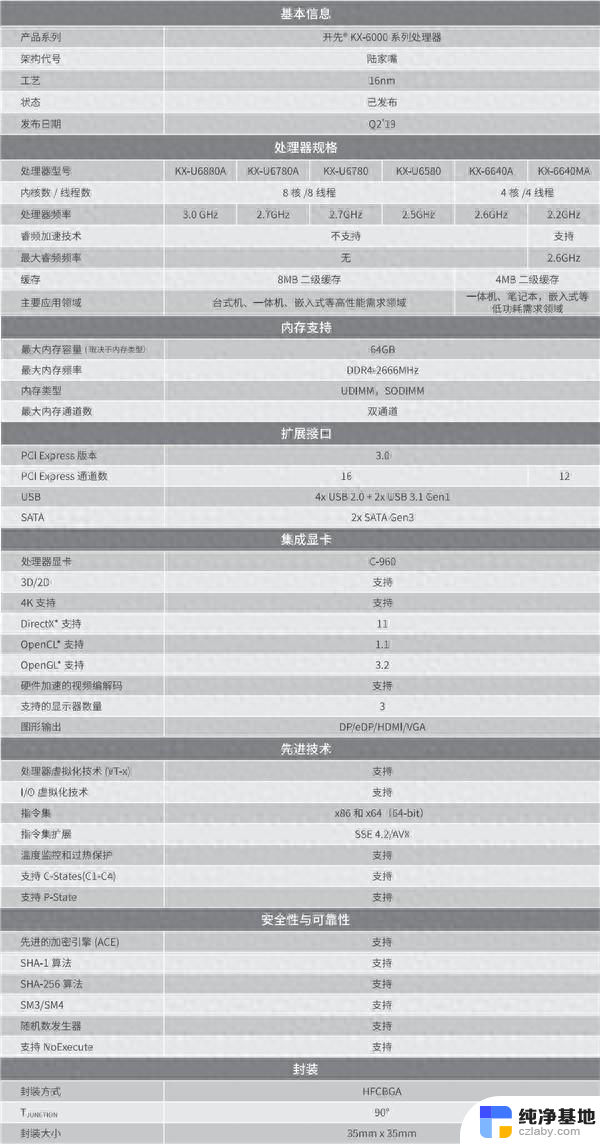

又一国产CPU性能曝光 追上AMD推土机架构核心,引领国内处理器市场

又一国产CPU性能曝光 追上AMD推土机架构核心,引领国内处理器市场2023-12-23

-

英伟达2023Q3销售50万块H100计算卡,服务器交付周期长达52周

英伟达2023Q3销售50万块H100计算卡,服务器交付周期长达52周2023-11-28

- 微软大客户订单激增,美国云计算三巨头继续保持高增长

- 国产最强X86 CPU发布:3.7GHz,性能提升200%,能装windows,颠覆市场!

- 微软Win11 Dev 26120.470发布:设置主页新增XGP推广,最新升级内容揭秘

- 微软AI革新:训练成本减半,微小模型引领语言学习新纪元最新

- 牙膏倒吸!第三代骁龙7 CPU跑分曝光 远低于天玑8300的惊人测试结果揭示

- 微软提高Win11 24H2硬件要求,影响哪些设备升级升级需求?

- Win10和Win7哪个好用?比较两个操作系统的优劣

- AMD 8400F性能和游戏体验评测:值得入手吗?

- 英伟达正式宣布“反转”计划,外媒称现在为时已晚

- 30 天倒计时警告,Windows 10 21H2 即将来临!别忘了更新系统

- 微软Win11更新22000.2960(KB5037770)修复了影响IE模式问题

- GPT-4o模型登陆微软Azure OpenAI服务,革新中文SEO技术!

微软资讯推荐

- 1 Win10和Win7哪个好用?比较两个操作系统的优劣

- 2 英伟达正式宣布“反转”计划,外媒称现在为时已晚

- 3 GPT-4o模型登陆微软Azure OpenAI服务,革新中文SEO技术!

- 4 微软承认部分Win11设备卡在26040/23620无法升级,解决方法大揭秘

- 5 浅谈国产六大CPU芯片厂商:发展现状与前景分析

- 6 微软秘密开发首个千亿大模型,竟由OpenAI对手操刀!- 一窥微软最新AI技术突破

- 7 国内会有吗?曝英伟达今年仅发布RTX 5090显卡,国内上市情况如何?

- 8 Windows 10市场份额重返 70% Windows 11继续下滑:用户回归主流操作系统

- 9 全新显卡推荐:2021年最佳显卡推荐及性能对比

- 10 NVIDIA已悄悄推出新RTX 4070,改用AD103核心,性能如何?

win10系统推荐

系统教程推荐