微软AI革新:训练成本减半,微小模型引领语言学习新纪元最新

今年以来,ChatGPT的推出引起了全球的广泛关注。这种基于自然语言处理的大型语言模型,其训练成本之高令人咋舌。微软研究人员为了解决这一难题,采用了一种新颖的训练方法:通过儿童故事来训练微小模型。

研究者们发现,这种训练方法使得微小模型能够迅速学会讲述连贯且符合语法的故事。这对于理解神经网络的内部机制具有重要意义。西雅图艾伦人工智能研究所的研究员钱德拉·巴加瓦图拉对此表示出了浓厚的兴趣。

神经网络,作为语言模型的核心,其结构灵感源自人脑。训练过程中,模型通过不断调整参数以提高生成文本与训练数据集的相似度,从而掌握单词预测的技能。这一过程中,模型需要学会多种不同的技能,如遵循语法规则和理解基本逻辑等。

然而,大型模型在训练时不仅学习了重要的规则,也学习了大量的无关信息。微软研究院的罗南·埃尔丹意识到,通过使用儿童故事,可以简化小型模型的训练过程,使其更易于管理。他利用大型语言模型生成的儿童故事,创建了一个训练数据集,以此来训练微小模型。

在训练过程中,埃尔丹和合作者李远志发现。层数较少但每层神经元较多的网络更擅长回答需要事实知识的问题,而层数较多且每层神经元较少的网络则更擅长追踪故事中的人物和情节。这一发现为未来大型模型的训练提供了新的视角。

这项研究的成功不仅在于为大型模型的训练提供了新的可能性,还在于为建立高质量的数据集提供了新的途径。微软的研究人员表示,合成训练数据的方法已经在十亿参数模型中显示出其有效性。

这一创新的研究方法预示着,即使是最简单的模型,我们仍有许多未知之处。未来,这项研究有望成为探索语言模型新领域的开端。

和讯自选股写手

风险提示:以上内容仅作为作者或者嘉宾的观点,不代表和讯的任何立场,不构成与和讯相关的任何投资建议。在作出任何投资决定前,投资者应根据自身情况考虑投资产品相关的风险因素,并于需要时咨询专业投资顾问意见。和讯竭力但不能证实上述内容的真实性、准确性和原创性,对此和讯不做任何保证和承诺。

微软AI革新:训练成本减半,微小模型引领语言学习新纪元最新相关教程

-

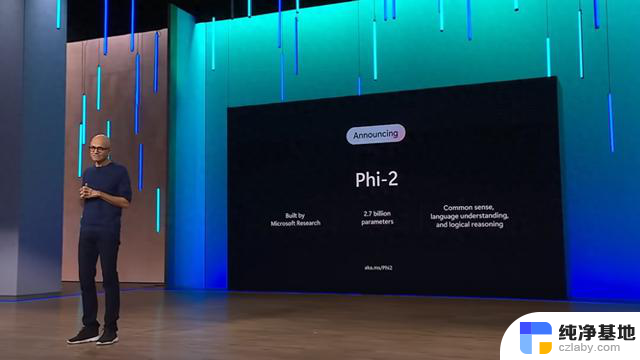

Phi-2:小语言模型媲美Llama 2 7B,微软新模型展现惊人威力

Phi-2:小语言模型媲美Llama 2 7B,微软新模型展现惊人威力2023-12-13

-

微软加入自定义GPT大战:AI技术新纪元的序幕,掀起AI技术革新的篇章

微软加入自定义GPT大战:AI技术新纪元的序幕,掀起AI技术革新的篇章2023-11-19

-

微软成立新人工智能团队,专注于小型模型开发

微软成立新人工智能团队,专注于小型模型开发2024-01-25

-

纽约时报起诉微软及OpenAI侵权:损失数十亿美元的大模型训练引发的关键词是?

纽约时报起诉微软及OpenAI侵权:损失数十亿美元的大模型训练引发的关键词是?2023-12-28

- OpenAI微软被纽约时报起诉!指控AI侵权,要求销毁模型和训练数据

- 微软推出Copilot AI键 为Windows 11电脑带来革新的全面评估

- OpenAI前CEO将加入微软,引领人工智能巨头联手迎接新挑战

- 材料学突破!微软MatterGen超越最先进模型,直接生成新材料稳定性提升2.9倍

- 又2名作家控告OpenAI与微软滥用作品训练AI,行为非常离谱

- 微软公司推出社交分享功能,引领科技巨头行业新潮流

- Windows10管理工具:如何有效管理您的Windows10系统?

- AMD锐龙9050系列“Strix Point”ES处理器现身Geekbench,性能曝光!

- 微软全屏弹窗提示Win10用户升级:“续命”费不便宜,如何避免高额费用?

- 今天小编分享 显卡进口攻略!以及显卡进口关税!最新解析

- 前白宫网络政策主管:微软是美国国家安全威胁的真相揭露

- 微软推出新型AI工具VASA-1,可将照片转化为逼真视频,让您的照片动起来

微软资讯推荐

- 1 今天小编分享 显卡进口攻略!以及显卡进口关税!最新解析

- 2 前白宫网络政策主管:微软是美国国家安全威胁的真相揭露

- 3 微软推出新型AI工具VASA-1,可将照片转化为逼真视频,让您的照片动起来

- 4 英伟达股价重挫1.8个宁德时代,AI龙头是否面临风险?

- 5 显卡市场2024:如何挑选最适合你的显卡?全面分析与推荐

- 6 微软网页版Outlook将于6月上线,支持Ctrl C/V复制粘贴邮件

- 7 绝对清晰的top中cpu指标的解释:如何理解和解释CPU的TOP中绝对清晰指标?

- 8 大模型超拟人合成技术PK赛:微软与讯飞谁更胜一筹?

- 9 中国显卡市场狂涨,英伟达股价暴跌,奖金绝缺!

- 10 英伟达H100 AI GPU短缺缓解,交货时间缩短至2-3个月

win10系统推荐

系统教程推荐